참고자료 ➡️ https://www.boostcourse.org/ai111/lecture/1108319

딥러닝 기초 다지기

부스트코스 무료 강의

www.boostcourse.org

U-Net

세부 구조와 계산:

1. 컨볼루션(Convolution):

- 커널을 사용하여 입력 이미지에서 특징을 추출함.

- 커널은 학습 가능한 매개변수로, 이미지의 공간적 특징을 학습함.

- 컨볼루션 연산의 수식:

- 풀링(Pooling):

- 최대 풀링(Max Pooling) 또는 평균 풀링(Average Pooling)을 사용하여 특징 맵의 크기를 줄임.

- 최대 풀링의 경우, 작은 영역 내에서 최대 값을 선택하여 다운샘플링 함.

- 업샘플링(Up-sampling):

- 디컨볼루션(Transposed Convolution) 또는 업샘플링(Interpolation)을 사용하여 이미지 크기를 복원.

- 디컨볼루션은 컨볼루션의 역연산으로, 특징 맵을 업샘플링 함.

- 스킵 연결(Skip Connections):

- 인코더 단계의 출력 특징 맵을 디코더 단계에 직접 연결하여, 세부 정보를 보존.

- 이로 인해 고해상도 세부 정보를 활용할 수 있음.

활용 및 응용:

- 의료 영상 분할:

- 세포, 장기, 병변 등의 분할에 사용.

- 예시: 뇌 MRI 영상에서 종양 분할.

- 위성 이미지 분석:

- 지리적 특징 분할, 토지 유형 분류 등에 사용됨.

- 생물학적 이미지 분석:

- 세포 구조 분할, 단백질 이미지 분석 등에 활용됨.

Transformer

세부 구조와 계산:

- Self-Attention:

- 입력 시퀀스의 각 요소가 다른 모든 요소와의 관계를 학습함.

- 각 요소의 가중치를 계산하여 중요도를 반영함.

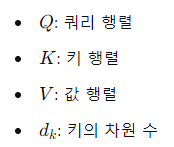

- 쿼리, 키, 값 행렬을 통해 자기 주의 메커니즘을 구현함.

- 어텐션 연산의 수식:

- 멀티헤드 어텐션(Multi-Head Attention):

- 여러 개의 독립적인 어텐션 헤드를 사용하여 다양한 관점에서 정보를 학습함..

- 각 헤드의 출력을 결합하여 더 풍부한 표현을 만듦.

- 멀티헤드 어텐션의 수식:

- 포지셔널 인코딩(Positional Encoding):

- 입력 데이터의 순서 정보를 반영하기 위해 위치 인코딩을 추가함.

- 이는 Transformer가 순서가 있는 데이터를 처리할 수 있음.

- 포지셔널 인코딩의 수식:

- 피드포워드 신경망(Feed-Forward Neural Network):

- 어텐션 레이어의 출력을 추가적인 비선형 변환을 통해 처리함.

- 각 레이어는 두 개의 선형 변환과 ReLU 활성화 함수로 구성됨.

활용 및 응용:

- 자연어 처리(NLP):

- 번역, 텍스트 생성, 문장 분류 등 다양한 작업에 사용됨.

- 예시: BERT, GPT 시리즈.

- 컴퓨터 비전:

- 이미지 분류, 객체 탐지, 이미지 생성 등에 사용됨.

- 예시: Vision Transformer (ViT).

- 음성 인식 및 합성:

- 음성 데이터의 처리 및 변환에 사용됨.

- 예시: Speech-Transformer.

관련 개념

- 컨볼루션 신경망(CNN):

- 이미지 데이터를 처리하는 데 최적화된 신경망 구조.

- 특징 추출을 위해 컨볼루션 레이어와 풀링 레이어를 사용함.

- 대표적인 모델: AlexNet, VGG, ResNet.

- 순환 신경망(RNN):

- 순서가 있는 데이터를 처리하기 위한 신경망 구조.

- 시퀀스 데이터를 처리하는 데 최적화되어 있음.

- 대표적인 모델: LSTM, GRU.

- 전이 학습(Transfer Learning):

- 사전 학습된 모델을 다른 작업에 재사용하여 훈련 시간을 단축하고 성능을 향상시킴.

- 이미지 처리에서 많이 사용되며, 사전 학습된 CNN 모델을 활용함.

- 자기 회귀 모델(Autoregressive Model):

- 이전 단계의 출력을 다음 단계의 입력으로 사용하는 모델.

- 시퀀스 데이터의 예측에 사용됨.

- 대표적인 모델: ARIMA, RNN 기반 모델.

- 비지도 학습(Unsupervised Learning):

- 레이블이 없는 데이터를 학습하여 숨겨진 구조를 발견함.

- 클러스터링, 차원 축소, 밀도 추정 등의 기법이 포함됨.

- 대표적인 모델: K-평균 클러스터링, PCA, Autoencoder.

➡️ U-Net과 Transformer는 각각 이미지 분할과 다양한 시퀀스 데이터 처리에 최적화된 모델.

U-Net은 이미지의 고해상도 세부 정보를 잘 보존하여 높은 분할 성능을 보여줌.

Transformer는 어텐션 메커니즘을 통해 장거리 의존성을 잘 학습하여 문맥 정보를 효과적으로 반영함.

728x90

반응형

'딥러닝' 카테고리의 다른 글

| 최적화 용어 정리 (0) | 2024.08.25 |

|---|---|

| Neural Network & MLP 개념 정리 (0) | 2024.08.22 |

| Neural Networks - MLP (0) | 2024.07.28 |

| 딥러닝 Historical Review - 고려대학교 최성준 교수님 (0) | 2024.04.11 |

| 데이터의 분리(Splitting Data) (0) | 2024.04.09 |